從傳統數據中心向以人工智能為核心的智算中心演進,不僅是硬件算力的堆砌,更是一場深刻的網絡技術變革。要打通這一轉型路徑,網絡技術的研發需在以下幾個關鍵環節實現突破與協同。

一、 互聯架構:從通用到異構,擁抱超大規模無損網絡

傳統數據中心網絡基于TCP/IP協議棧,為通用計算設計,存在延遲、丟包和擁塞等問題。而智算中心的核心——大規模AI集群訓練(如萬卡集群)對網絡提出了近乎嚴苛的要求:超高帶寬、超低延遲、零丟包。因此,技術研發必須聚焦:

- RDMA(遠程直接內存訪問)技術的深度應用與優化:繞過操作系統內核,實現服務器間內存的直接、高速訪問,是降低延遲的關鍵。需要解決RDMA大規模部署下的流量控制、擁塞管理、與現有基礎設施融合等問題。

- 新型互聯協議與交換架構:如InfiniBand,憑借其原生無損特性和低延遲,已成為高端智算網絡的主流選擇。基于以太網的RoCE(RDMA over Converged Ethernet)技術也在快速發展,旨在將以太網的生態優勢與RDMA的高性能結合,其核心在于通過PFC(優先級流控制)、ECN(顯式擁塞通知) 等機制實現“無損以太網”。研發重點在于提升RoCE的規模化部署能力和穩定性。

- 非阻塞網絡拓撲:采用Clos、Dragonfly+ 等拓撲結構,構建無阻塞、高帶寬、多路徑的網絡平面,以滿足成千上萬個加速卡(GPU/ASIC)間全連接通信的需求。

二、 計算與網絡的協同設計:解耦與重構

智算中心中,計算(GPU/NPU)與網絡的關系從“連接”變為“融合”。技術環節包括:

- 片間互聯與節點內互聯:在單個服務器節點內部,多顆加速卡之間通過NVLink、PCIe 等高速互聯技術形成緊密耦合的計算單元。網絡技術需與這些內部互聯協議高效對接,形成統一的內存地址空間和通信域。

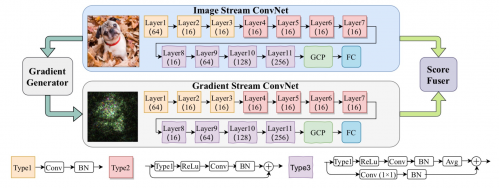

- 網算一體與智能網卡(DPU/SmartNIC):將部分網絡、存儲和安全功能從CPU卸載到專用的數據處理單元(DPU)或智能網卡上。這不僅能解放CPU資源,更能實現網絡協議的在網處理、集合通信優化(如All-Reduce操作的部分卸載),從而大幅提升整體系統效率。這是研發的前沿熱點。

三、 網絡智能化與可觀測性:從被動運維到主動調度

智算工作負載(尤其是分布式訓練)動態多變,網絡必須更加智能。

- AI賦能的網絡自治:利用機器學習模型預測流量模式、實時檢測與規避擁塞、自動優化路由策略,實現網絡的自配置、自修復、自優化。

- 端到端的精細化可觀測性:部署細粒度的遙測技術(如INT,帶內網絡遙測),實時采集網絡路徑上的延遲、丟包、隊列深度等數據,并結合訓練作業的語義信息(如迭代周期),快速定位性能瓶頸是在計算、存儲還是網絡,實現跨層調優。

四、 光互聯技術:突破帶寬與距離的物理極限

隨著單芯片速率向800G、1.6T發展,電互聯在功耗和距離上的瓶頸日益凸顯。光互聯 技術成為必然選擇:

- CPO(共封裝光學)和NPO(近封裝光學):將光引擎與交換芯片或計算芯片封裝得更近,極大降低接口功耗和尺寸,是未來超高速互聯的核心方向。

- 高速光模塊與硅光技術:研發更低功耗、更低成本的800G/1.6T高速光模塊,利用硅光技術實現光電集成的大規模生產。

五、 軟件定義與自動化:統一編排的基石

硬件變革需要軟件定義來驅動。

- 統一通信庫與編排:優化NCCL、OneCCL 等集合通信庫,使其能充分感知底層異構網絡(IB、RoCE)的拓撲和特性,實現最優通信算法選擇。

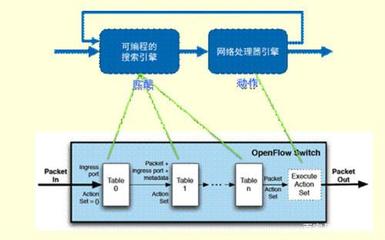

- 云網智一體化的資源調度:通過軟件定義網絡(SDN)和智能編排器,將網絡資源(帶寬、拓撲)與計算資源(GPU)、存儲資源作為一個整體進行統一調度和彈性分配,根據AI任務的需求動態生成最優資源組合。

而言,從數據中心到智算中心的網絡技術打通,是一條從“通用互聯”走向“智算融合” 的路徑。它要求研發不再局限于單純的帶寬提升,而是需要圍繞無損傳輸、異構協同、網算一體、智能運維和光電融合等多個維度進行系統性的創新與整合。只有打通這些環節,網絡才能從“管道”進化為智能計算的“神經系統”,真正支撐起智算時代的萬千應用。